Il New York Times ha raccontato l’incontro avvenuto la scorsa settimana tra alcuni dei personaggi più influenti nel mondo della tecnologia. Il tema principale della discussione sembra sia stata la ricerca di un’etica nello sviluppo delle intelligenze artificiali, soprattutto nel mondo del lavoro

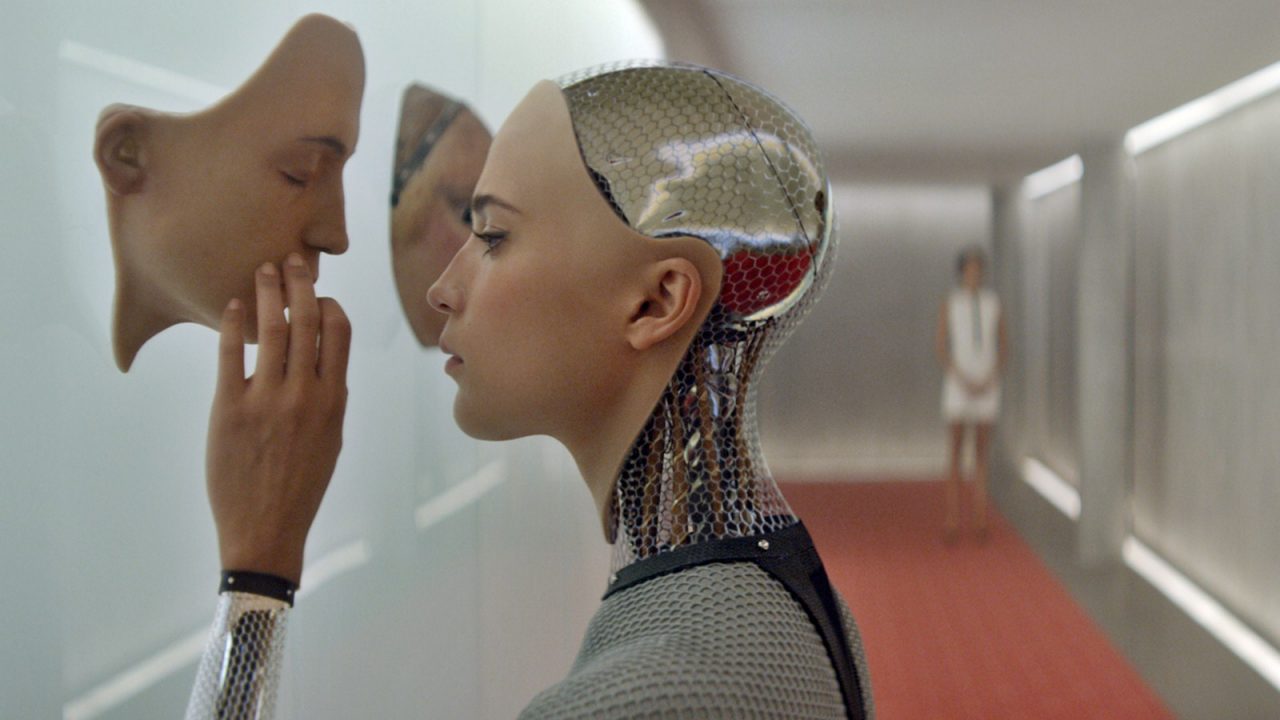

I precedenti letterari e cinematografici. Il genere fantascientifico ci ha spesso proposto pellicole e libri dove il tema dell’etica nel mondo delle intelligenze artificiali e della robotica era in primo piano. Gli esempi di film cult nei quali avanzati androidi finivano per ribellarsi ai propri creatori, nonostante tutte le precauzioni, sono davvero molti, e l’ultimo, in ordine di tempo è il geniale Ex Machina. Sono altresì famose le tre leggi di Asimov della robotica, sviluppate negli anni Quaranta e spiegate nei suoi libri. I principi cardine sono la tutela e l’obbedienza agli essere umani e il rifiuto di ogni azione autodistruttiva.

Il punto di partenza però, allo stato attuale dello sviluppo, è ancora molto lontano per destare preoccupazioni su eventuali rivolte di androidi o di un’ascesa al potere delle macchine. Le questioni più concrete, che hanno riunito attorno al tavolo i rappresentanti di cinque colossi tecnologici, riguardano l’impatto delle nuove intelligenze artificiali nel mondo del lavoro, del trasporto e nei conflitti armati.

Cinque giganti riuniti. Cinque delle più grandi compagnie tecnologiche del mondo hanno concentrato gli sforzi per cercare di determinare uno standard di etica intorno alla creazione di intelligenze artificiali: Alphabet, holding di Google, Amazon, Facebook, IBM e Microsoft. Le compagnie di questo settore – scrive il New York Times hanno fatto grandi promesse sulle potenzialità delle macchine ad intelligenza artificiale. Negli anni recenti però, il campo delle I.A. ha compiuto il più rapido balzo in avanti che si sia mai visto, a partire dalle auto a guida autonoma e macchine che capiscono i nostri discorsi, come Amazon Echo, fino a una nuova generazione di sistemi di guerra che potrebbero automatizzare il combattimento.

Non è ancora stato rivelato cosa il gruppo di imprenditori abbia detto o deciso di fare ma, secondo quanto trapelato, le intenzioni sono chiare: assicurarsi che la ricerca sulle I.A. sia focalizzata sull’aiutare le persone e non danneggiarle.

Le prime difficoltà potrebbero riguardare la cooperazione stessa tra aziende così potenti e così competitive tra loro, non è infatti ancora chiaro come questo regolamento potrà essere redatto e soprattutto accettato da tutti gli operatori del settore. In passato però è già successo che le compagnie del settore tech concentrassero gli sforzi e mettessero da parte le rivalità per raggiungere un risultato ottimale negli interessi di tutti. Negli anni Novanta infatti, le aziende hanno lavorato insieme per stabilire un metodo standard per criptare le transazioni nell’e-commerce, ponendo le basi per il boom del business su internet.

Un memorandum intanto è circolato tra le cinque compagnie e al suo interno è contenuto un piano provvisorio per annunciare una nuova organizzazione dei lavori per la metà di settembre. Uno dei punti rimasti ancora in sospeso, secondo quanto rivelato da una persona coinvolta nei negoziati, è che Google DeepMind, una società sussidiaria di Alphabet, ha richiesto di partecipare separatamente.

Il gruppo di industriali seguirebbe il modello di un’organizzazione per i diritti umani molto simile, chiamata Global Network Initiative, in cui le corporazioni e organizzazioni non governative sono concentrate sulla libertà di espressione e privacy nel settore informatico.

Gli studi sull’argomento. L’importanza dell’impegno da parte delle aziende è sottolineato in uno studio rilasciato da un team della Stanford University fondato da Eric Horvitz, un ricercatore di Microsoft diventato punto di riferimento per questo dibattito. Lo studio ha l’obiettivo di spiegare quale sarà l’impatto delle I.A. nella nostra società ogni cinque anni per il prossimo secolo.

Secondo alcuni però sarà impossibile regolare le I.A. in maniera corretta almeno fino a quando non ci sarà una chiara definizione delle I.A., che ad oggi viene considerata in maniera molto differente a seconda delle correnti di pensiero. La raccomandazione contenuta nel report è di aumentare l’attenzione sull’argomento ed approfondirlo a tutti i livelli di governo, con un incremento degli investimenti sulle I.A. sia da parte del settore pubblico che del privato.

Lo studio di Stanford prova a definire i problemi che i cittadini di una tipica cittadina del Nord America dovranno affrontare con computer e sistemi robotici che imitano le capacità umane. Gli autori hanno esplorato otto aspetti della vita moderna, inclusa la salute, l’educazione, l’intrattenimento, l’occupazione, ma senza considerare l’aspetto bellico. I ricercatori hanno spiegato che l’applicazione dell’I.A. militare non rientrava nei loro interessi, ma non hanno escluso uno studio futuro proprio su questo campo.

Il report inoltre non considera la credenza di alcuni esperti di computer a proposito della possibilità di una “singolarità” che potrebbe portare le macchine ad essere più intelligenti degli uomini e magari a minacciarli. «È stata una decisione volontaria non dare adito a questa possibilità nel nostro documento», ha spiegato il Dottor Stone, ricercatore informatico all’Università del Texas di Austin e uno degli autori.

Intanto Reid Hoffman, fondatore di LinkedIn con un passato nel settore dell’I.A., sta discutendo con il Massachussetts Institute of Technology Media Lab per fondare un progetto che esplori gli effetti sociali ed economici dell’intelligenza artificiale. Sia l’M.I.T. che l’associazione degli industriali stanno cercando di collegare i progressi tecnologici in maniera più stretta con i problemi economici e politici. Il gruppo di studio dell’M.I.T. ha discusso anche l’idea di progettare le nuove I.A. e i nuovi sistemi robotici con «la società nei circuiti».

La frase è un riferimento ad un dibattito a lungo termine sulla progettazione di computer e droidi che continuino a necessitare dell’interazione con gli uomini. Ad esempio, il Pentagono ha recentemente iniziato un’articolata strategia militare che prevede l’utilizzo di I.A. nelle quali l’uomo continua a controllare le decisioni più importanti, come se uccidere o meno, invece che delegare la responsabilità alla macchina. «Il principale problema è che gli scienziati informatici non sono stati bravi ad interagire con sociologi e filosofi – ha spiegato Joichi Ito, il direttore dell’MIT Media Lab e membro del consiglio nella direzione del New York Times – Quello che vogliamo è supportare e rafforzare gli sforzi dei sociologi che hanno fatto ricerche che potrebbero giocare un ruolo fondamentale nel decidere le politiche future».