Minority Report diventa realtà Il software che prevede i crimini

L’azienda giapponese Hitachi ha annunciato alla fine del mese scorso, precisamente il 29 settembre, di avere progettato una tecnologia in grado di predire i crimini, e dunque di prevenire qualsiasi situazione di pericolo per la sicurezza. I portavoce di Hitachi - società che, tra l’altro, coltiva i propri interessi in vari ambiti, dai sistemi di sicurezza agli ascensori e dalle ferrovie alle tecnologie nucleari – hanno annunciato che il loro programma, battezzato col nome di Visualization Predictive Crime Analytics (PCA), sarà impiegato negli Stati Uniti e nei paesi caraibici. A partire da ottobre, sarà sottoposto ad un periodo di prova in circa mezza dozzina di città americane, inclusa (forse) Washington D.C. Sebbene l’azienda nipponica non abbia menzionato la capitale staunitense, infatti, voci di corridoio lasciano presagire che il sistema anti-crimine verrà usato anche lì.

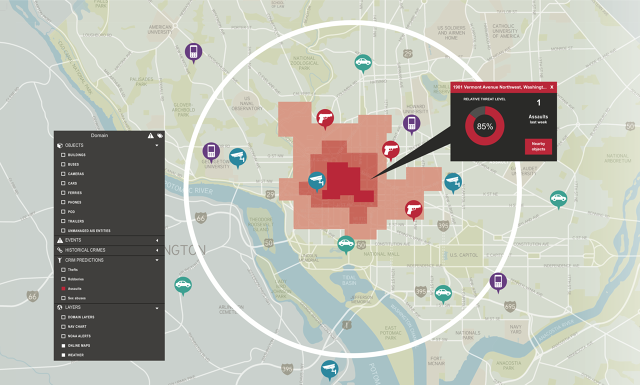

Altro che fantascienza. Il Visualization Predictive Crime Analytics incrocia un’enorme quantità di dati, tra cui i percorsi dei mezzi pubblici, le conversazioni vocali e sui social, le condizioni metereologiche e così via. La nuova tecnologia riesce a digerire e combinare fiumi di dati provenienti da sensori e da molteplici fonti Internet. Il sistema dà la possibilità agli agenti di polizia di modificare alcune variabili sulla base della loro esperienza, così da combinare la precisione della macchina con l’intuito professionale dell’uomo. Secondo i test finora condotti, e secondo quanto garantisce la Hitachi, il programma è in grado di individuare il luogo di un crimine che deve ancora essere compiuto con una precisione di 200 metri quadrati e associarvi un livello di minaccia compreso tra lo 0 e il 100 percento. Il PCA, inoltre, possiede un’interfaccia molto chiara, con mappe colorate per indicare le zone più a rischio e con indicatori inequivocabili come pistole, telefoni cellulari e telecamere della sorveglianza.

Non siamo in Minority Report. Tutto ciò è possibile grazie alla cosiddetta machine learning, un processo informatico che ricorre al software noto come “R”, che mastica tutte le informazioni che riceve per trovare collegamenti e per delineare scenari a cui un essere umano non sarebbe in grado di giungere. «Una persone non riesce a gestire decine o centinaia di variabili che potrebbero influenzare un crimine», afferma Darrin Lipscomb, un manager della divisione Public Safety and Visualization dell’Hitachi, e cofondatore delle compagnie Avrio e Pantascene, quelle che hanno sviluppato la tecnologia acquistata da Hitachi, nel settembre 2014. Ma che cos’è, di preciso, questa machine learning? Ovviamente non ha nulla a che vedere con i precog, i tre umani mutanti del film Minority Report, capaci di vedere il futuro e di anticipare le mosse dei criminali (guarda caso, dalla pellicola di Spielberg del 2002 è stata tratta una nuova serie trasmessa in questi mesi dalla Fox TV).

Cos’è il machine learning. È la nuova fase dell’intelligenza artificiale. Gli scienziati del computer stanno costruendo sistemi informatici che “imparano” analizzando e combinando tra loro masse di dati enormi, per potere visualizzare fin nei minimi dettagli contesti particolarmente complessi o anomalie in scenari a rischio (ad esempio, quelli nelle zone di guerra). Ma questo sistema è diventato fruibile sono recentemente, con lo sviluppo dei “granai” delle informazioni e con l’avanzamento delle capacità dei processori, come l’Amazon Web Services, Microsoft Azure e l’HDS dell’Hitachi. L’azienda giapponese non è l’unica compagnia che offre servizi di sicurezza, ma ciò in cui si distingue è il fatto di permettere al computer di derivare predizioni dai dati, anziché far loro selezionare solo le informazioni più importanti.

La tecnologia predittiva e l’investigazione. Applicare il machine learning al metodo investigativo è un grande cambiamento, hanno rilevato sia Lipscomb e Mark Jules, sua cofondatore all’Avrio e Pantascene. Di solito i poliziotti costruiscono modelli predittivi basandosi sulla loro esperienza e tenendo conto di alcuni elementi variabili, come la localizzazione di scuole o le parole in gergo per la droga che compaiono su Twitter, continua Jules. Il sistema della Hitachi, invece, non richiede una persona per capire quali variabili sono importanti, e quanto lo sono. «Devi solo inserire quei set di dati e il computer decide, in circa due settimane, se ci sono e quali sono le correlazioni», afferma Jules. Il PCA usa l’abilità di un computer di comprendere un testo colloquiale o un discorso. Può analizzare conversazioni sui social network e stabilire cosa sta accadendo in una precisa posizione geografica, anche se i soggetti coinvolti usano il linguaggio in codice delle gang.

Dubbi e controindicazioni. Le prospettive sul futuro aperte dal PCA destano non pochi quesiti, di natura sia giudiziaria sia, più in generale, etica. I presunti criminali arrestati sulla presunta scena del crimine dovranno essere arrestati, anche se, nella realtà, non hanno compiuto nulla? Oppure la polizia dovrebbe entrare in azione mentre il crimine si sta già compiendo? Prevedere quali saranno le decisioni dei diversi governi in questo campo è praticamente impossibile. E inoltre, cosa accadrebbe se il sistema fallisse e degli innocenti venissero fermati? Lipscomb ha affermato che accadrebbe piuttosto l’opposto, e cioè che la pratica adottata da alcuni corpi di polizia di arrestare e poi rilasciare, come ad esempio accade a New York, sarebbe subito sospesa. L’abitudine di pattugliare quartieri a rischio e di fermare persone qualunque sarebbe sostituita da interventi più mirati. E pure meno discriminatori, prosegue sempre Lipscomb: al momento le persone fermate e/o perquisite dalla polizia di New York sono per l’85 percento afroamericani. In ogni caso, l’applicazione sistematica del PCA dipenderà dal periodo di prova che inizierà il prossimo mese. Solo dopo questa fase preliminare la polizia confronterà le predizioni della macchina con quello che è realmente accaduto. In questo modo, si potrà capire quanto sia effettivamente affidabile il sistema. La Hitachi, inoltre, ha promesso di rendere pubblici i risultati ottenuti durante la fase di test, per garantire il massimo di trasparenza. Resta ancora aperto e da discutere, invece, il problema relativo alla violazione della privacy. Forse è proprio questo l’aspetto a cui si dovrà prestare più attenzione, se la prova del PCA dovesse andare a buon fine.